데이터 유출, 보안, 비용 등 우려 해소 가능…기업 및 기관 실수요 확대

[컴퓨터월드] 최근 국내 모든 산업군에서 혁신의 아이콘으로 부상한 기술이 있다. 바로 거대언어모델(LLM, Large Language Model)이다. 올해 초 챗GPT(Chat Generative Pre-trained Transformer)가 국내에 실험 버전으로 공개되면서 국내 기업들은 LLM에 주목하기 시작했다. 2016년 알파고와 이세돌 9단과의 대전에 기업들이 인공지능(AI)에 관심을 보였던 것과 같은 양상이다.

기업과 공공기관들의 시선이 챗GPT에서 자연스럽게 LLM으로 옮겨가고 있다. 기업들은 내부에 LLM을 구축하고 활용해 업무 효율성을 향상하고 서비스 고도화를 꾀하고자 ‘자체 구축형 LLM’에 많은 관심을 보이고 있다. LLM의 개념과 구축 과정 등 현황을 비롯해 관련 기업들의 동향 등을 짚어본다.

기계번역에서 RNN으로 변화…이제는 트랜스포머로 세대교체

모델(Model)은 복잡한 현실 세계를 추상화된 방법으로 표현하는 것을 의미한다. 모델이라는 단어에 ‘언어’라는 단어가 결합된 언어모델은 인간의 언어 처리 과정을 재현·표현할 수 있는 추상화된 방법이라는 뜻을 담고 있다. 컴퓨터가 인간의 언어 처리 과정에서 다음 단어를 예측하도록 하는 하나의 표본이자 모형이다. 언어모델은 단어, 문장 및 문맥을 포함하는 텍스트 데이터셋으로 학습되며, 학습을 마친 언어모델은 텍스트를 생성, 번역, 요약, 이해하는 데 사용된다.

챗GPT 등장 이후 이제는 일반명사가 돼버린 언어모델은 1957년 컴퓨터 과학자 조지 밀러(George Miller)가 언어모델 이론을 발표하면서부터 알려지기 시작했다. 조지 밀러가 주창한 언어모델 이론의 핵심은 단어의 확률 분포를 기반으로 텍스트를 생성할 수 있다는 것이다. 이후 1960년대, 1970년대에 들어 언어모델 연구가 활발히 진행됐으며 텍스트를 생성하고 언어를 번역하고, 텍스트를 요약하는 데 사용되기 시작했다.

1980년대와 1990년대, 컴퓨터(HW)의 성능이 향상되면서 언어모델 연구는 발전에 가속도가 붙게 된다. 이 당시 언어모델은 통계기반 기계번역이 주류를 이뤘다.

통계기반 기계번역은 원문(원시언어)과 번역문(목적언어)으로 이뤄진 병렬 말뭉치(쿠퍼스)를 이용하는데 원시언어에 나타난 어휘의 번역과 번역된 어휘를 목적언어에 맞게 표현하는 언어모델로 구성됐다.

이에 대해 올거나이즈 신기빈 최고인공지능책임자(CAIO)는 “언어모델의 근간은 통계기반 기계번역이다. 가령 ‘I’am a student(나는 학생이다)’라는 말을 한국어로 번역할 때 ‘나는 학생이다’와 같이 올바르게 번역할 수 있지만, ‘나는 이다학생’, ‘학생 나는이다’ 등 잘못된 문장으로 번역할 수 있다. 이를 제대로 배열하기 위해선 언어모델을 다양한 문맥에 맞춰 학습시켜야 한다. 여기서 ‘I am’이라는 단어 뒤에는 한국어로 ‘학생’, ‘직장인’, ‘개발자’ 등 직업이 나올 통계(확률)를 계산하고, 통계치를 고려해 문법에 맞게 자연스럽게 문장을 생성하는 방식이다. 이 과정에서 앞과 뒤 문맥, 전반적인 글 문맥 등 다양한 환경적 요인도 고려해야 한다”고 설명했다.

통계기반 기계번역 이후에는 순환신경망(RNN) 기반 언어모델이 등장했다. RNN 언어모델은 입력된 시퀀스(단어 혹은 문장)를 처리하기 위해 순환구조를 이용하는 신경망 모델이다. 구체적으로 RNN은 시간이 경과함에 따라 변화하는 시계열 데이터 등 직전의 출력값도 입력값으로 취급하는 신경망을 의미한다.

RNN 언어모델은 직전 시퀀스 데이터를 기반으로 다음 시퀀스를 추출하는 구조다. 직전의 문장이 다음에 오는 문장과 밀접하게 연관돼 정확도가 높다는 점 때문에 기계번역의 주류로 부상했다.

RNN 언어모델은 1980년대에 처음 개발됐다. 그러나 당시에는 HW 성능이 낮아 대규모 데이터셋을 학습하기 어려웠다. 2010년대 들어 컴퓨팅 성능이 크게 향상되면서 RNN 기반 언어모델이 주목받기 시작했다.

최근에는 RNN 언어모델을 대체하는 새로운 아키텍처가 등장했다. 바로 트랜스포머(Transformer) 기반 언어모델이다. 트랜스포머는 2017년 구글AI가 발표한 논문인 ‘Attention is All You Need’에서 처음 소개된 아키텍처다. 어텐션 메커니즘(Attention Mechanism)을 이용해 입력된 시퀀스의 모든 위치를 고려하는 구조다.

트랜스포머 언어모델은 RNN 언어모델보다 더 긴 문맥을 만들 수 있고, 성능도 고도화됐다. 트랜스포머의 등장은 자연어처리(NLP) 분야에 큰 영향을 미쳤고, NLP 분야 새로운 표준으로 자리를 잡았다.

거대언어모델(LLM)의 대표주자로 꼽히는 GPT도 트랜스포머 언어모델을 기반으로 하고 있다. 이에 대해 바이브컴퍼니 윤준태 인공지능(AI)·빅데이터 연구소장은 “트랜스포머는 크게 입력 시퀀스를 처리하는 인코더와 출력 시퀀스를 생성하는 디코더로 구분돼 있는데, 인코더는 어텐션 메커니즘을 이용해 입력 시퀀스의 위치를 고려하고 디코더는 인코더에서 생성된 출력 시퀀스를 사용해 다음 단어를 예측하는 구조”라면서 “GPT(Generative Pre-trained Transformer)는 트랜스포머의 디코더를 이용해 생성된 언어모델이다. 때문에 어텐션 메커니즘을 채용해 입력된 시퀀스의 모든 위치를 고려한다. 이것이 GPT가 자연스러운 텍스트를 생성할 수 있는 이유다”라고 설명했다.

실제로 네이버의 ‘하이퍼클로바’, LG엑사원의 ‘엑사원 2.0’, 오픈AI의 ‘GPT’는 트랜스포머의 디코더만 이용하고 있으며, KT의 ‘믿음’은 인코더와 디코더 두 가지를 모두 이용하고 있다.

Q. 네이버클라우드의 ‘하이퍼클로바’에 대해 소개해달라.

A. ‘하이퍼클로바(Hypercloba)’는 2021년 우리가 보유한 슈퍼컴퓨터와 네이버 생태계에 있는 방대한 데이터를 활용해 개발한 초거대 AI다. 국내 기업 최초로 도입한 700페타플롭스(PF) 성능의 슈퍼컴퓨터를 활용해, 대용량 데이터 처리를 위한 인프라를 안정적으로 구축했다. 하이퍼클로바는 오픈AI가 공개한 파라미터 1,750억 개를 학습한 GPT-3를 넘어서는 2,040억 개 파라미터를 토대로 개발됐다. 한국어 데이터 학습량은 GPT-3의 6,500배 이상이다. 하이퍼클로바의 성능은 NLP 분야 학회 ‘EMNLP(Empirical Methods in Natural Language Proessing) 2021’에서 메인 트랙에 채택되며 세계적으로 인정받았다.

Q. 네이버클라우드가 AI 기술 고도화를 위해 어떠한 노력을 하고 있는가.

A. 네이버클라우드는 하이퍼클로바의 AI 고도화를 위해 반도체 솔루션을 개발하고 있으며, 모델 경량화 기술을 적용하고 있다. 먼저 AI 특화 반도체를 개발 중이다. 삼성전자와 함께 LLM의 연산과 학습, 추론에 필요한 기능을 모두 갖추면서도, 기존 GPU 대비 1/10 크기의 모델 사이즈, 4배 이상의 전력 효율성을 갖춘 경량화된 AI 반도체 솔루션을 구축하고 있다. 아울러 LLM 경량화에도 총력을 기울이고 있다. 자체 개발한 AI 경량화 기술을 활용해 하이퍼클로바, 클로바노트 등 주요 기술과 서비스를 최적화하고 있다.

아울러 LLM을 개발하기 위한 기반 인프라인 데이터센터와 클라우드에도 투자하고 있다. 하반기 오픈을 앞둔 데이터센터 ‘각 세종’은 60만 유닛 이상의 서버를 수용할 수 있는 하이퍼스케일 데이터센터다. 초대규모 AI를 운영하는 데에 필요한 엄청난 컴퓨팅 파워를 안정적으로 운영할 수 있다.

이달 공개될 하이퍼클로바X에 필요한 컴퓨팅 파워가 급격히 증가하더라도 각 세종 내 상면을 적시에 활용해 신속하고 안정적으로 컴퓨팅 파워를 공급할 수 있다. LLM을 효율적으로 운용하기 위해서는 클라우드 기술과의 결합도 필수적이다. 네이버는 올해 AI 기술 조직 ‘클로바’를 네이버클라우드에 통합해 클라우드 기반 초거대 AI 생태계 확장에 선제적으로 대응하고 있다.

Q. 이달 출시 예정인 하이퍼클로바X에 대해 소개해달라.

A. ‘하이퍼클로바X’는 하이퍼클로바의 고도화된 LLM이다. 구체적으로 머신러닝을 통해 방대한 데이터를 미리 학습해 추론하고 이를 문장으로 표현할 수 있는 생성형 AI의 원천 기술이다. 사용자가 채팅하듯 질문을 하면 학습한 데이터를 기반으로 사람처럼 문장을 만들어 답할 수 있다.

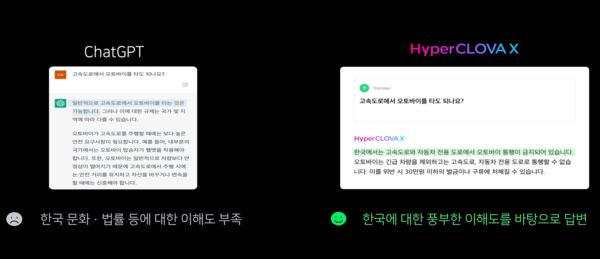

하이퍼클로바X의 한국어 성능은 GPT-3.5의 영어 답변 성능 이상이다. 특히 사용자가 질문을 하면 답변을 하는 속도가 챗GPT보다 훨씬 빠르며, GPT-3.5보다 한국어 데이터를 6,500배 더 많이 학습했다.

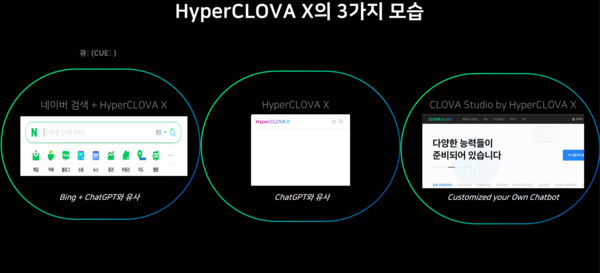

구체적으로 공개할 순 없지만 크게 △클로바X △큐:(Cue:) △하이퍼클로바X 기반 클로바스튜디오 등 3가지 서비스로 출시될 예정이다. 먼저 대화형 에이전트 ‘클로바X’는 입력된 질문에 답변하는 서비스다. 글을 쓰고 요약할 수 있어 개인 생산성 도구로 이용할 수 있다. 다양한 서비스를 플러그인 형태로 연동해 필요한 기능도 호출할 수 있다.

다음으로는 생성형 AI 기반 검색 서비스 ‘큐:(Cue:)’다. 9월에 베타서비스로 공개될 예정인 이 서비스는 하이퍼클로바X를 바탕으로 개발된 검색 특화 생성형 AI 서비스다. 네이버가 구축한 콘텐츠를 바탕으로 새로운 검색 경험을 제공한다. 특히 복합적인 의도가 포함된 긴 질의를 이해하고 검색 계획을 수립할 수 있다. 또 답변 생성에 필요한 신뢰도 있는 최신 정보를 활용해 입체적인 검색 결과를 제공한다.

아울러 올해 10월부터는 B2B 비즈니스도 진행할 예정이다. 네이버 클라우드 플랫폼(NCP)을 통해 서비스 중인 하이퍼스케일 AI 도구 ‘클로바 스튜디오’에 하이퍼클로바X 모델이 탑재된 버전을 공개할 계획이다. 이달 중 일부 기업에 선공개한다. 공식 출시는 10월이다. 기업 고객은 자체 데이터를 하이퍼클로바X에 결합해 자체적인 생산성 향상 도구를 구축하거나 맞춤형 AI 서비스도 만들 수 있다. 자체 구축형 LLM인 셈이다.

LLM으로의 변화

최근에는 트랜스포머를 기반으로 하는 언어모델에 새로운 변화가 나타나고 있다. 바로 방대한 양의 데이터와 파라미터(매개변수(Parameter))를 학습한 거대언어모델(LLM, Large Language Model)이다. 파라미터는 시스템 및 언어모델 구동에 영향을 주는 요소를 의미한다. 가령 요리와 관련된 언어모델일 경우 굽기, 재료, 가재도구 등 개별적인 요소가 여기에 해당된다. 언어모델의 결괏값에 영향을 주는 변수라는 의미로 통용된다.

‘거대’라는 타이틀을 붙일 수 있는 명확하고 특정한 기준이 정해진 것은 아니다. 국내 이 분야 전문가들은 ‘거대’의 기준으로 GPT-3가 학습한 파라미터 개수인 1,750억 개를 들고 있다. 다만 최근에는 동일한 파라미터 개수를 학습했어도 얼마나 많은 데이터를 넣는지, 예제 학습은 얼마나 했는지 등에 따라 성능이 달라지기 때문에 이러한 부분도 고려해 LLM을 규정해야 한다는 주장도 있다. LLM은 파라미터 개수 증가에 따라 모델의 크기가 커지면서, 기존 언어모델에 비해 성능이 향상됐다.

많은 파라미터를 학습하지 않고도 출력값의 성능을 높일 수 있는 ‘인-컨텍스트 러닝(ICL, In-Context Learning)’에 대한 관심도 늘고 있다. 인-컨텍스트 러닝은 주어진 프롬프트나 문맥을 LLM이 학습하고 해당 문맥과 관련된 텍스트를 생성한다.

ICL은 크게 △퓨샷(Few-Shot) △원샷(One-Shot) △제로샷(Zero-Shot) 3가지 방식으로 구분된다. 이에 대해 올거나이즈 신기빈 CAIO는 “먼저 퓨샷은 질의를 주는 과정에서 몇 개의 예제를 제공하기만 해도 해당 예제를 통해 지시하는 바를 이해하고 정확한 답변을 할 수 있는데, 이를 퓨샷이라고 한다. 비슷하게 예제를 주지 않는 것을 제로샷, 하나만을 제공하는 것을 원샷이라고 한다”고 설명하며 “GPT-3와 같은 수준의 LLM이라면 제로샷이나 원샷과 같은 지시문에 대해서도 꽤 정확하게 답변을 제공할 수 있음을 확인했다”고 말했다.

일례로 이용자가 “오늘 월급이 들어와 기쁘다”와 같은 프롬프트를 입력하면, LLM 기반 GPT는 “축하합니다. 제가 도와드릴 일이 있을까요?”와 같은 출력을 생성할 수 있다. 기쁘다라는 앞 문맥을 파악하고 여기에 맞는 답변을 말하는 구조다. 이는 LLM 기반 GPT가 방대한 텍스트 말뭉치를 교육했고 언어와 인간 감정을 이해할 수 있기 때문이다.

파라미터 및 토큰 수 확대 및 SFT 등 방법으로 성능 고도화

물론 LLM은 전통적인 언어모델에서 발전했기에 다른 언어모델과 구조적으로 유사성을 보인다. 하지만 LLM만의 고유 특성이 있다. 바로 창발 능력(Emergent Ability)이다. LLM은 언어모델에 비해 많은 학습데이터, 큰 규모의 파라미터, 고성능 HW가 필요하다. 기본적인 언어모델과 학습 방법, 데이터 인풋, 아웃풋 등 구조적으로는 유사성을 보인다.

다만 LLM에서는 설명할 수 없는 현상인 창발이 발생한다. 더 많은 학습데이터와 더 큰 모델을 사용하기 때문에 특정 순간이 되면 성능이 극적으로 향상된다. 이로 인해 기존 언어모델에서는 불가능했던 태스크를 수행할 수 있다. 창발이란 하위 계층(구성 요소)에 없는 특성이나 성능이 상위 계층(전체 구조)에서 자발적으로, 혹은 돌발적으로 출현하는 현상을 말한다.

일반적으로 언어모델의 성능 향상을 그래프로 그릴 경우 완만한 우상향 곡선 형태지만, LLM의 그래프는 계단식으로 상승하는 모양이다. 한번 크게 늘어나는 순간에 창발이 발생한다는 의미다.

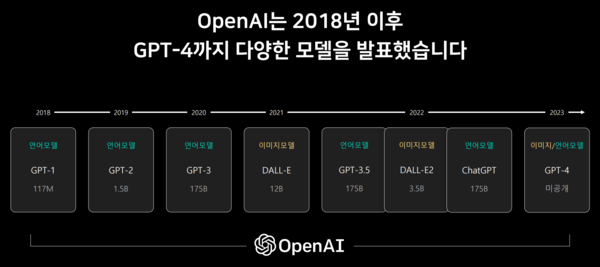

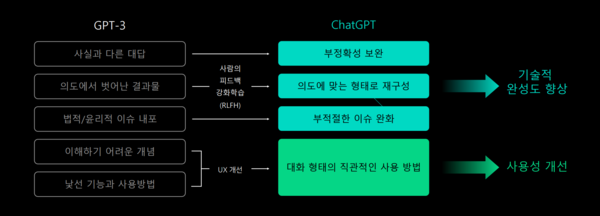

일반적으로 LLM의 성능을 높이기 위해서는 고성능의 HW가 필요하다. 하지만 여건상 HW에 투자가 힘든 기업들이 많다. 이들 기업들은 더 많은 파라미터와 토큰 그리고 데이터를 학습하는 방식을 채용한다. 오픈AI는 GPT-1에서 1억 1,700만 개, GPT-2에서 15억 개, GPT-3에서 1,750억 개로 버전을 업그레이드 할 때마다 더 많은 파라미터를 학습시켰다. 다만 챗GPT로 잘 알려진 GPT-3.5는 GPT3과 동일한 수의 파라미터 개수를 지녔다. GPT-4는 아직 공개되지 않았다.

메타는 지난달 공개한 라마2에 70억 개, 130억 개, 700억 개의 파라미터로 학습한 모델을 공개했다. 네이버클라우드가 이달 24일 공개할 예정인 ‘하이퍼클로바X’는 2,040억 개, LG엑사원의 ‘엑사원2.0’은 3,000억 개의 파라미터를 학습한 것으로 알려진다.

토큰은 통상 데이터와 동일한 개념으로 쓰인다. 토큰을 정의하는 명확한 기준은 없지만, 업계 관계자들에 따르면 통상 형태소 개수를 기준으로 삼고 있다. 이용자가 LLM에 입력값을 넣고 출력값을 받는 일련의 프로세스에서 출력 값을 형태소 단위로 구별한 단위를 토큰이라고 칭한다. 예를 들어 ‘You are a reporter’라는 답변을 받을 때, 발생하는 토큰은 4개(You, are, a, reporter)다. 이용자는 일반적으로 이 토큰의 양을 기준으로 이용료를 지불한다.

토큰은 LLM과 밀접한 관계를 맺고 있다. LLM을 개발한 기업의 정책에 따라 토큰의 수가 결정되며, 같은 의미의 결괏값을 받더라도 언어에 따라서 토큰은 다르게 계산된다. 이에 대해 네이버클라우드 정주환 하이퍼클로바 에반젤리스트는 “한국어 특화 LLM이 필요한 이유가 여기에 있다. 실제로 챗GPT와 하이퍼클로바를 같은 문장으로 토큰 비교를 검사해봤다. 챗GPT의 토크나이저를 기준으로 36토큰이, 하이퍼클로바는 7토큰이 계산됐다. 한국어의 특성과 문맥을 더 잘 이해할 수 있는 LLM이 필요한 이유다. 챗GPT보다 한국어에 더 특화된 LLM은 하이퍼클로바다”라고 설명했다. 현재 오픈AI가 제공하는 챗GPT의 경우에는 토큰 이용료를 계산할 수 있는 ‘토크나이저(Tokenizer)’를 제공하고 있다.

파라미터 개수가 많으면 일반적으로 LLM의 성능은 향상된다. 하지만 파라미터 개수가 많다는 것은 LLM을 구동하는 컴퓨팅 인프라를 과도하게 이용한다는 의미이기도 하다. 파라미터가 많은 LLM을 구축하기 위해서는 그에 걸맞은 GPU 서버가 필요하다.

그렇다면 파라미터 개수가 최소화하면서 성능을 향상할 수 있는 방법은 없을까. 업계 관계자들에 따르면, 일반적으로 LLM이 공개되기 전 슈퍼바이지드 파인 튜닝(SFT, Supervised Fine Tuning) 작업을 끝내는데, 이 과정에서 몇 차례 더 SFT를 수행하며 사용처에 특화된 튜닝 작업을 이어가는 ‘SFT 오버피팅(Overfitting)’ 작업이나 ‘모델링 아키텍처’를 통해 성능을 개선할 수 있다고 한다. 현재 대부분 LLM 관련 업계에서는 이 방법을 통해 성능을 개선하고 있다.

Q. 바이브컴퍼니의 LLM 제품에 대해 소개해달라.

A. 우리는 ‘바이브 젬’이라는 한국어 특화 LLM을 보유하고 있다. 오픈소스인 ‘폴리글롯’을 기반으로 개발된 LLM이다. 바이브 젬의 버전은 파라미터 개수에 따라 크게 13억 개, 58억 개, 128억 개 3가지로 제공된다. 크게 △응용 지향적 LLM △산업 전문적 LLM △한국어 특화 LLM △강화학습 기반 LLM 등 4가지 핵심 특징이 있다.

먼저 응용 지향적 LLM은 태스크 맞춤형으로 인스트럭션(Instruction)을 생성하고 학습할 수 있다. 또한 검색 기반 모델과 결합한 생성형 기술로 할루시네이션 현상을 최소화한 다중 문서 요약 기능을 제공한다. 아울러 데이터 요약기능과 문서 작성 기능을 위한 인스트럭션 학습도 제공한다.

다음으로 각종 산업에도 특화됐다. 공공기관이나 도서관, 행정문서 등 다양한 전문 도메인의 데이터를 학습할 수 있으며, 특히 금융 산업과 관련된 다량의 데이터를 학습했다. 텍스트나 그래프, 표 등 경제‧공공부문의 다양한 비정형 데이터를 처리하고 이해할 수 있는 기능도 갖추고 있다. 세 번째는 한국어에 특화됐다. 한국어 특성을 반영한 독자적인 인스트럭션을 생성하고 학습할 수 있다. 또 거대 한국어 말뭉치를 기반으로 튜닝됐다.

마지막으로 강화학습에 기반한 LLM이라는 점이다. 사용자의 의도에 맞는 답변을 생성하기 위한 ‘인스트럭션-팔로잉(Instruction-Following)’ 모델을 갖추고 있다. 생성한 답변에 대한 사람의 피드백 점수를 ‘리워드 모델’로 학습시켰으며, 사용자 만족도 점수가 높은 출력을 생성하도록 정책 모델을 최적화했다.

Q. 바이브 젬 기반 솔루션은 어떤 것이 있는가.

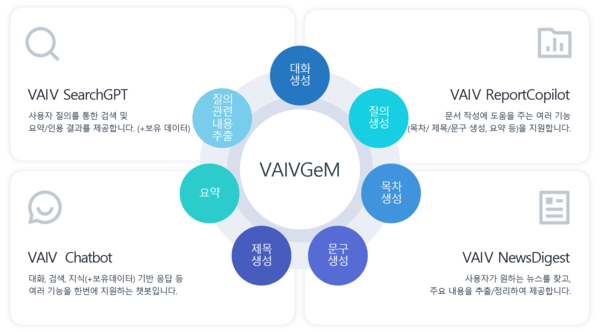

A. 솔루션은 △바이브 서치GPT(VAIV SearchGPT) △바이브 리포트코파일럿(VAIV ReportCopilot) △바이브 챗봇(VAIV Chatbot) △바이브 뉴스다이제스트(VAIV NewsDigest) 등 총 4가지다. 바이브 서치GPT는 기업이 보유한 문서를 검색하고 바이브 젬을 통해 핵심 내용에 대한 요약 결과를 제공하는 서비스다. 참조한 문서를 함께 근거로 제시해 요약 결과에 대한 2차 검증이 가능하다.

다음으로 바이브 리포트코파일럿은 문서 작성에 도움이 되는 기능을 제공하는 솔루션이다. 대표적으로 목차 생성, 제목 생성, 보유 문서에 대한 내용 요약, 시계열 데이터 기반 설명 생성 등이 있다. 문서 작업이 많은 기업의 부담을 줄일 수 있다. 세 번째로 바이브챗봇은 질의-응답 쌍에 대한 시나리오가 필요없는 생성형 AI 기반 챗봇이다. 바이브 젬을 통해 보유한 데이터를 입력하면 자동으로 질의-응답 쌍을 생성해 지식기반 챗봇을 이용할 수 있도록 지원한다. 또 바이브 서치GPT와 같은 챗 기반으로 다양한 서비스를 연계할 수도 있다.

마지막으로 바이브 뉴스다이제스트다. 이 서비스는 수요기업이 원하는 문서의 조건을 정의하면, 조건에 맞는 문서를 필터링하고 주요 내용을 추출하고 요약한 뒤 제공한다. 바이브컴퍼니는 비정형데이터 분석 엔진을 보유하고 있으며, 현재 뉴스와 소셜데이터를 대상으로 분석 서비스를 제공하고 있다. 특정 기업이나 주제에 관련된 뉴스를 지속적으로 트래킹해야 할 경우에는 매일 오전 관련 내용에 대한 요약 보고서를 받을 수 있다.

Q. 바이브 젬 기반 솔루션이 기업 및 기관에 어떠한 영향을 줄 것으로 보는가.

A. 기업의 경쟁력 강화에 큰 도움을 줄 것이다. 기관에는 대민서비스의 혁신을 가져다 줄 것이다. 예를 들어보겠다. 최근 바이브컴퍼니에서 바이브 젬을 기반으로 개발한 금융서비스가 있다. LLM이 자동으로 금융 애널리스트들의 업무를 대체할 수 있다. 실제로 애널리스트를 통해 보고서를 받을 경우 비용이 상당하며, 애널리스트들은 보고서 작성을 위해 분기에 한 번 회사 방문이나 데이터, 자료 등을 취합해 작성한다. 기간이 오래 걸리며 100대 기업이나 150대 기업으로 한정된 정보만 제공할 수 있다.

이를 매일매일 비용을 투입하지 않고 중소기업의 정보까지 리포트로 만들어주고, 사업 전략과 전망을 각 매체의 기사에서 취합해 요약까지 해준다. 특히 긍정, 중립, 부정 등 관련 주가 전망 뉴스들도 발굴해 근거로 함께 붙여준다. 애널리스트가 작성한 리포트처럼 깊이가 깊지는 않지만 그들이 취급하지 못하는 영역도 커버할 수 있다.

기업으로서는 비용을 절감하고 보다 핵심적인 업무에 고급인력을 투입할 수 있고, 타 경쟁사에 비해 서비스도 고도화할 수 있다. 결국 경쟁력 향상으로 이어질 것이다. 기관도 마찬가지로 대민서비스에 필요한 정보를 사람이 일일이 찾는다는 것은 비효율적이다. 이를 LLM을 기반으로 처리한다면 업무 혁신, 더 나아가 대민서비스 혁신으로도 이어지게 될 것이다.

유출 사고로 오픈소스 LLM 아류작 출현

LLM은 오픈소스로 공개된 것과 이를 상용화한 제품들이 모두 국내에 공급되고 있다.

오픈소스 제품으로는 현재 메타에서 개발한 오픈소스 ‘라마(Llama, Large Language Model Mode AI) 2’, 뉴아틀라스의 ‘알파카(Alpaca)7B’, 딥마인드의 ‘쥬라기-1 점보(Jurassic-1 Jumbo)’, 구글 AI에서 개발한 ‘메가트론-튜링 NLG(Megatron-Turing NLG)’ 등을 들 수 있다. 한국어에 특화된 오픈소스 LLM으로는 튜닙이 배포한 ‘폴리글롯(Ploy Glot)’이 있다.

업계 일각에서는 메타에서 개발한 오픈소스 LLM인 ‘라마 1’의 유출 사고가 오히려 오픈소스 LLM이 발전한 것으로 평가하고 있다. 올해 3월 14일 라마 1의 소스코드와 기타 관련 문서들이 온라인을 통해 몇몇 개발자들에게 유출됐다. 보안 취약점이 노출됐고, 악의적인 목적으로 사용될 수 있다는 우려를 자아냈다.

하지만 라마1의 유출은 오히려 대중들로부터 LLM에 대한 관심을 불러일으켰고, 메타가 자체 인력을 투입해 추진해야 했던 업데이트가 외부 개발자들의 손을 거치며 완성됐다. 라마1이 유출되기 이전 LLM은 노트북에서 구동되지 않을 만큼 사용에 제약이 있었다. 하지만 라마1은 느리기는 하지만 노트북에서 구동됐고, 이에 개발자들이 라마1을 기반으로 아류작인 ‘돌리’, ‘비쿠나’와 같은 오픈소스 LLM을 만들어냈다. 라마1 유출 사고가 오히려 오픈소스 LLM의 탄생을 본격화한 것으로 평가하는 이유이다.

또 오픈소스 LLM 탄생을 주도했던 몇몇 개발자들은 메타 측에 이왕 공개됐으니 아예 상업용으로도 이용할 수 있도록 배포해달라는 요청을 하기도 했다. ‘라마를 해방하라(Free the Llama)’라는 그림이 인터넷상에 유행처럼 퍼진 것도 요청을 들어주라는 개발자들의 주장이 반영된 것이었다고 볼 수 있다.

물론 메타 측은 “아직 준비가 안 됐다”면서 요청을 거절했지만, 결국 상업용으로도 LLM을 이용할 수 있도록 공개하는 전략으로 방향을 틀었다. 업계 관계자는 “메타 입장에서는 자사 중심의 오픈소스 LLM 생태계를 구축할 수 있고, 기술 개발에도 크게 도움을 받을 수 있을 것이다. 기술은 많은 사람이 이용할수록 진화하기에 무료로 피드백과 보완이 이뤄질 수 있다. 이런 프로세스가 오픈소스의 근간이기도 하다. 메타는 이를 적절히 활용하고자 상업용으로도 공개하며 세를 키우고자 할 것”이라고 설명했다.

자체 구축 LLM 수요 증가…기업·기관 설치용으로 ‘sLLM’ 각광

국내·외 많은 기업들은 챗봇의 기능을 한참 앞선 것으로 평가받는 LLM 도입에 나서고 있다. 이들 기업은 주로 업무 효율화를 위해 LLM 도입을 고민하고 있다. 하지만 비용 특히 하드웨어 비용이 문제로 지적된다. 기업이나 기관에서 LLM을 구축할 경우 LLM을 구동할 수 있는 HW 인프라가 요구된다. 파라미터 개수가 많으면 많을수록 더 많은 컴퓨팅 자원이 필요해 HW에 대한 투자가 선행돼야 한다.

일반적으로 LLM을 구동하기 위해선 GPU 장비가 필요한데, 대표 제품인 엔비디아의 A100의 경우 ‘엔비디아 A100 텐서코어 GPU 80GB’의 경우 약 2,145만 원에 달하며 제품이 공급되는 기간도 12주~20주 가까이 소요되는 것으로 알려진다. 한 단계 높은 등급 제품 ‘엔비디아 H100 80GB’의 경우 약 5,700만 원이다.

이런 비용부담을 줄이기 위해 LLM 공급기업들은 자사 LLM을 간소화·최적화한 sLLM(small Large Language Model)을 제안하고 있다. 실제로 올거나이즈의 경우 sLLM 제품인 ‘알리 GPT’를, 바이브컴퍼니는 ‘바이브 젬(Gem)’을 제안하고 있다.

사실 sLLM을 풀이하면 작은 거대언어모델이다. 문법적으로는 이해할 수 없는 단어다. sLLM을 쉽게 설명하면 고객사의 요청에 따라 LLM을 간소화하고 최적화한 것이라 할 수 있다.

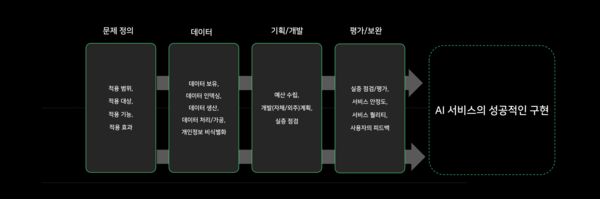

sLLM을 구축하는 과정은 기업별로 차이가 있지만 일반적으로 △구축 목적 수립 △구축 데이터 수집 △LLM 구축 △LLM 평가 △LLM 배포 등 크게 5가지 절차로 이루어진다.

먼저 LLM 구축 목적을 수립해야 한다. 예를 들어 LLM을 사용해 자사의 서비스를 고도화할지 혹은 자체적으로 마케팅이나 교육, 연구 등에 sLLM을 적용할지 결정해야 한다. 이후 sLLM을 구축할 데이터를 수집해야 한다. sLLM은 기업이 활용하고자 하는 영역에 적합한 데이터를 학습해야 하기 때문이다.

이에 대해 네이버클라우드 정주환 하이퍼클로바 에반젤리스트는 “각 기업이 가지고 있는 문제에 대한 정의와 보유하고 있는 데이터에 대한 특성 파악이 중요하다. 기업이 가진 문제가 무엇이고 LLM이 이러한 문제를 해결할 수 있는지, 그리고 현재 보유하고 있는 데이터 형태에 따른 추가적인 학습 혹은 전처리 과정이 수반돼야 한다”고 설명했다.

이러한 수집 절차가 마무리되면 sLLM을 구축한다. 가장 일반적인 구축 방법은 사전 훈련된 sLLM을 기업의 환경에 맞춰 파인 튜닝(Fine Tuning)한다. 쉽게 말해 기업이 원하는 대로 sLLM을 이용하고 원하는 수준의 결과를 얻기 위한 조정 작업을 해야 한다는 것이다.

다음으로 구축된 sLLM을 평가한다. 통상 sLLM 평가 척도는 정확도, 효율성, 사용자 만족도 등이다. 이 같은 일련의 작업이 모두 마무리된 이후 sLLM을 배포한다.

이에 대해 올거나이즈 신기빈 CAIO는 “기업에서 LLM을 구축할 때 가장 핵심적인 부분은 바로 데이터다. ‘쓰레기를 넣으면 쓰레기가 나온다(Garbage in Garbage out)’는 말과 같이 기업이 원하는 것을 얻기 위해선 양질의 데이터와 다양한 종류의 데이터가 필요하다”며 “일반적으로 기업이 자체적으로 보유한 데이터를 위주로 학습하지만, 외부에서 수집한 데이터도 학습한다. 하지만 품질이 떨어지는 데이터를 아무리 많이 넣어봤자 비효율적인 학습만 하게 된다. 외국 논문에 따르면, 잘 정제된 데이터는 조금만 넣어도 잘 학습될 경우 좋은 결과를 보인다고 한다. 이처럼 데이터의 품질이 LLM 구축에 지대한 영향을 준다”고 조언했다.

바이브컴퍼니 윤준태 AI‧빅데이터 연구소장은 “sLLM 구축이 잘 끝나더라도 운영과 유지보수, 업데이트가 중요하다. 학습 파이프라인과 데이터 관리 체계 등을 잘 점검하고 만들어야 기업이 원하는 대로 잘 이용할 수 있고 업데이트도 용이하다”고 첨언했다.

할루시네이션 현상 해결해야

물론 LLM 기반 생성형 AI는 아직 완벽하지 않다. 여러 문제점이 있지만 대표적인 문제로 ‘할루시네이션 현상(Hallucination)’이 있다. 할루시네이션이란 환각이란 뜻으로 AI 모델이 허위정보를 진짜인 것처럼 답하는 현상을 뜻한다. 할루시네이션 문제를 해결하지 못하면 신뢰성 있는 AI를 구축하기 어렵기 때문에 적용이 불가능하다.

실제 챗GPT를 비롯해 여러 서비스에서는 보통 질문을 하면 답변(생성 결과)만을 제공한다. 이 경우 사용자는 답변이 사실인지 아닌지에 대해서 재차 검증해야 하는 상황이 발생할 수 있다. 또 이러한 검증에는 많은 노력이 필요하다. 이를 해결할 수 있는 방법은 결괏값에 대한 근거를 제시하는 것이다.

바이브컴퍼니는 할루시네이션 문제를 완화하기 위해 먼저 답이 있는 문서를 찾고 그것을 기반으로 답을 작성하는 방법을 채택하고 있다. 이를 위해서는 무엇보다도 정답이 있는 문서를 찾아내는 것이 중요하다. 바이브컴퍼니는 딥러닝 기반의 단락 검색과 기계 독해 기술을 접목해 성능을 높였다. 정확한 답이 포함된 문서를 기반으로 답변을 생성하기 때문에 할루시네이션 문제가 완화될 수 있다.

LG엑사원도 학습 DB에서 관련 문서를 탐색한 뒤 다양한 근거를 기반으로 추론해 답변을 생성하고 출처도 제공하는 방식을 채택하고 있다. LG 배경훈 AI연구원장은 “트랜스포머 기술 특성상 할루시네이션은 발생할 수밖에 없다”며 “엑사원 2.0이 할루시네이션을 100% 해결한 건 아니지만 이런 문제를 줄이는 동시에 근거를 명확하게 제공하는 데 주력했다”고 밝힌 바 있다.

할루시네이션 문제를 기술적으로 완벽히 없앨 수는 없지만, 지속적인 AI 학습과 여러 기능을 통해 일부 완화할 수 있다는 것이 업계 관계자들의 중론이다.

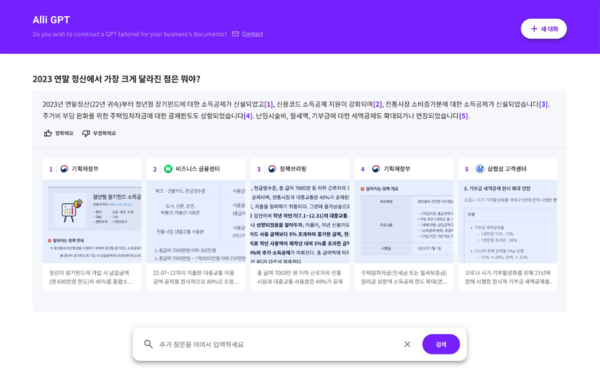

Q. ‘알리 GPT’에 대해 소개해달라.

A. 알리GPT는 기존 올거나이즈가 보유한 NLP AI 인지검색 솔루션인 알리에 챗GPT의 기반 언어모델인 오픈AI의 GPT-3.5 API를 연동해 기업 맞춤형으로 엔지니어링한 AI 솔루션이다. 주로 답변을 요약하거나 내용을 분석해 추세를 알려주는 등의 역할을 하고 있다. 기업의 문서 및 메뉴얼, 최신 정보를 ‘알리GPT’에 업로드하면 질문에 대한 답을 문서에서 찾아 요약하고 이를 이해해 답변해준다. 대내‧외 업무에 챗GPT를 활용하고자 하는 기업을 위해 정확한 최신 정보를 업데이트 할 수 있다.

이를 도입할 경우 기업은 챗GPT에 익숙한 사용자들이 질문형 검색을 하면 요약‧종합된 답을 받을 수 있다. 또한 시계열로 변화하는 정보나 여러 팀에 흩어져 담당자를 여러 명 찾아야 하는 정보도 통합해 제공할 수 있으며 B2B2C 형태에서 쌓인 고객 문의 데이터를 알리GPT에 올려 고객 문의를 자동화하는 방식으로 사용할 수 있다.

알리GPT 외에도 ‘알리 LLM 옵스(Ops)’도 존재한다. 이 솔루션은 오픈소스 LLM을 활용해 기업이 자체 시스템에 LLM을 독자적으로 구축할 수 있는 서비스다. 민감한 개인정보를 다루거나 데이터 유출을 걱정하는 기업들을 위해 출시한 제품이다. 알리에서 AI 기반 업무 자동화 시나리오를 만들 때, 원하는 LLM을 선택해 활용할 수 있다.

현재 돌리(Dolly), 스테이블LM, 블룸(Bloom) 등 파라미터 30억~1,760억 개의 오픈소스 LLM을 기업이 원하는 대로 자유롭게 선택해 도입할 수 있다. 오픈AI의 GPT나 구글의 바드 등 빅테크 기업의 LLM을 선택해 서비스형 소프트웨어(SaaS) 형태로 활용할 수 있도록 서비스를 제공하고 있으며, 이들 기업의 LLM을 사용해도 각 기업의 특성에 맞게 파인튜닝을 하기 때문에 기업 특화 프롬프트 엔지니어링 및 버전 관리가 용이하다.

Q. 올거나이즈만의 기술 차별점은 무엇인가.

A. 크게 자연어 인지검색 기술과 트레이닝 데이터 없는 ML, 진화를 거듭하는 AI 태스크봇 등 3가지 부문 기술에 차별성을 보유하고 있다. 먼저 자연어 인지검색 기술이 뛰어나다. 자연어 이해(NLU) AI가 문장의 의미와 의도를 이해해 동일한 내용을 다른 형태로 질문해도 정확한 결과를 제시한다. 가령, 보험사에서 ‘새 차 뽑았어’ 혹은 ‘자동차 보험에 가입하고 싶어’라고 AI 태스크봇 알리에 검색하면 ‘자동차 보험’에 대한 답을 찾아준다. 이처럼 정확한 자연어 인지검색이 가능한 이유는 올거나이즈의 AI 모델이 PDF, MS워드, 파워포인트, 엑셀 등 정제되지 않은 데이터도 레이블(Label) 데이터로 만들어 머신러닝을 할 수 있을 만큼 고도화돼있기 때문이다.

아울러 트레이닝 데이터가 없어도 머신러닝을 바로 이용할 수 있다. 실제로 공공데이터로 학습시킨 산업별(금융, 리테일, 석유/화학 등) AI 모델로 레이블 데이터 없이도 바로 연결해서 사용할 수 있다. 이 경우 도입 즉시 70%의 정확도를 자랑한다. 만약 고객사가 보유하고 있는 데이터로 트레이닝(파인 튜닝)하고 알리 사용자의 피드백을 반영(강화학습)할 경우 수 주 내 정확도를 95%까지 끌어올릴 수 있다.

마지막으로 AI의 답변 근거를 문서에서 하이라이트 해 보여주기 때문에 할루시네이션 우려를 덜 수 있다. AI가 틀린 답을 제시할 경우 실시간으로 결괏값을 수정할 수 있다. 섬(thumb) 업‧다운 버튼을 눌러 피드백을 할 수 있다. 결괏값 수정 제안과 피드백은 사용자별로 가중치를 적용할 수 있다. 신입사원의 피드백보다 임원의 피드백에 더욱 많은 가중치를 두는 것이 대표적인 예다.

Q. 제품의 성능 기능도 중요하지만, 이를 잘 사용하는 것도 중요할 것 같은데.

A. 사실 가장 중요한 부분이다. 흔히 대화형 LLM의 경우 프롬프트(Prompt)라는 명령어로 답변을 받는다. 더 높은 품질의 응답을 얻으려면 해당 모델이 잘 이해하고, 잘 작동할 수 있는 프롬프트를 만드는 것이 핵심이다. 고객들에게 제안하는 프롬프트 명령 내리는 좋은 방법은 크게 6가지다. 쉽고 간결한 표현, 열린 질문보단 닫힌 지시문을 사용해야 하며, 수행할 작업의 조건을 구체적으로 명시해야 한다. 또 지시문의 맥락을 함께 제공해야 하며 원하는 결과물 형식의 예시를 함께 입력해야 한다. 마지막으로 충분히 사용해 봐야 한다.

물론 기업에 구축한 LLM은 기업 이용자에 특화돼 명령문의 중요성이 크게 부각되지는 않는다. 하지만 개인의 AI 역량을 함양하기 위해서는 프롬프트를 잘 작성하는 노력도 함께 해야할 것이다.

증권사 필두로 전 산업군 확대

할루시네이션이라는 문제가 존재하지만 그럼에도 생성형 AI, 그 중에서도 생성형 텍스트 AI 적용은 전 산업군으로 확대되고 있다. 바이브컴퍼니 윤준태 AI‧빅데이터 연구소장은 “LLM 기반 구축형 AI는 전 산업군으로 확대될 것이다. 일례로 보험사의 보험약관 데이터를 학습시켜 보험에 대한 고객들의 문의 등 인바운드 상담에 대응할 수 있고, 판례 등 법률 데이터를 학습해 로펌 내에서 업무에 활용 수 있다. 특히 구축형의 경우에는 보안이 우선시되는 많은 기업이나 기관에서 활용도가 매우 높을 것으로 기대된다”고 설명했다.

여러 산업군에서의 관심을 보이고 있지만 업계 관계자들은 보험, 카드, 은행, 증권 등 금융사의 LLM 도입이 가장 먼저 이루어질 것으로 예상하고 있다. IT 신기술 도입에 가장 보수적인 금융권이 움직인다는 것은 그만큼 검증됐다는 것을 의미한다고 볼 수 있다. 업계에 따르면 국내 대표 증권사 2곳이 한 기업과 LLM 도입 컨설팅을 진행하고 있으며, 두 증권사 모두 증권 분석 도우미로 활용할 예정인 것으로 알려진다.

정부 역시 기업, 공공의 초거대 AI 사업을 육성하기 위해 ‘초거대 AI 활용지원 사업’을 추진하고 있다. 이 사업은 정부가 초거대 AI를 보유한 기업을 선정하고 수요기관 및 기업이 도입할 수 있도록 지원하는 사업이다. 네이버클라우드, KT, 바이브컴퍼니 등이 공급기업으로 선정됐다. 현재 관세청, 국회도서관, 조달청, 뤼튼테크놀로지, 한전KPS, 스켈터랩스 등 공공기관 및 민간 기업들에 대한 컨설팅이 진행되고 있으며, 컨설팅 결과를 토대로 자체 구축형 LLM을 도입하게 된다.