데이터 레이크 구축, 단일한 데이터 플랫폼 등 사용자 접근성이 핵심 쟁점

[컴퓨터월드] 데이터를 효과적으로 수집·저장·활용하는 것은 모든 기업들이 마주하고 있는 최우선 과제다. 데이터는 기업이 단기적인 비즈니스 결정을 내릴 수 있도록 지원할 뿐만 아니라, 때로는 미래를 예측하고 전사적인 혁신을 일으키기 위한 근거가 되고 있다. 이에 따라 전 세계 기업들은 보다 많은 데이터를 효과적으로 수집하고 분석하기 위해 다양한 데이터 전략을 수립하고 있다.

전 세계 기업들이 데이터를 효과적으로 활용할 수 있도록 돕는 국내외 벤더사들을 통해, 이들이 제시하는 최적의 데이터 전략에 대해 들어봤다.

데이터, 기업 경쟁력의 핵심 지표

오늘날 데이터는 기업의 경쟁력을 결정짓는 중요한 요소 중 하나로 자리 잡았다. 보유하고 있는 데이터의 절대적인 양, 데이터에서 유의미한 인사이트를 추출해낼 수 있는 분석 역량, 분석 결과를 실제 비즈니스에 효과적으로 적용할 수 있는 체계적인 프로세스 등, 기업이 정확한 의사결정을 내리고 성공적인 비즈니스 활동을 펼치기 위해서는 데이터 관련 역량이 필수다. 이제 전 세계 기업과 기관들은 중요한 문제가 발생했을 때 데이터를 기반으로 의사결정을 내리는 것을 당연하게 여기게 됐다.

금융·통신·제조·유통 등 산업 규모가 크고 각각의 의사결정이 큰 의미를 같은 분야에서는 이미 우선적으로 데이터 관련 기술과 인프라 도입을 서둘러왔다. 하지만 이제 데이터 과학(Data Science)은 일부 선도기업만의 전유물이 아니라 모든 산업계 전반의 보편적인 기술로 정착하고 있다. 데이터 과학이 실제 비즈니스에 긍정적인 영향을 미치는 사례들이 축적되면서 산업계의 관심과 신뢰도가 높아지고, 이는 비즈니스 문제를 데이터 과학로 해결하려는 시도가 증가하는 결과로 이어지고 있다.

과거에는 비즈니스와 직접적으로 관련된 데이터를 수집 및 분석해 미래를 예측하고 의사결정을 지원했으며, 이후 보다 방대하고 실시간 정보를 수용할 수 있는 빅데이터의 중요성이 강조되면서 더욱 강력하고 정확한 데이터 관리 역량이 필요해졌다. 최근에는 데이터 관리와 분석을 위한 하드웨어(HW), 소프트웨어(SW) 기술이 발전하면서, 기업과 시장 전체를 아우르는 거시적인 관점에서의 데이터 활용만이 아니라 고객 한 명 한 명에게 최적화된 서비스를 제공할 수 있는 개인화된 서비스가 주목받고 있다. 또한 인공지능(AI)과 머신러닝 기술과 결합해 데이터 관리와 활용 사이클을 자동화하거나 실시간으로 유의미한 인사이트를 확보하고자 하는 시도가 이어지고 있다.

이미 각 산업분야의 선도기업들은 데이터를 실시간으로 확보할 수 있는 채널과 인프라를 다양화하고 보다 효과적·효율적으로 변환·분석이 가능한 데이터 아키텍처 마련에 박차를 가하고 있다. 데이터 중심의, 혹은 데이터 주도적인(Data-Driven) 비즈니스 프로세스를 마련하기 위해서는 ▲다양한 채널을 통해 데이터를 수집·저장하고 ▲수집된 데이터의 품질과 메타데이터를 관리하고 ▲사용자가 원하는 대로 분석·활용할 수 있어야 한다.

전사 데이터 아우르는 ‘싱글 뷰’ 갖춰야

엔터프라이즈 데이터 플랫폼 기업 클라우데라가 발표한 보고서(“Critical Success Factors to Achieve a Better Enterprise Data Strategy in Multicloud Environment”, 2019.9)에 따르면, 전 세계 약 70%의 조직이 포괄적인 데이터 전략과 역량을 비즈니스 목표를 달성하기 위한 핵심 요소로 인식하고 있다. 하지만 현재 갖춰진 데이터 전략·역량이 충분하다고 생각하는 조직은 35%에 불과했다. 이들은 기존의 비즈니스 인텔리전스(Business Intelligence, BI) 및 데이터 웨어하우스(Data Warehouse, DW)과 같은 전통적인 데이터 기술을 활용해 전체의 7~80%에 달하는 데이터를 처리·활용하고 있었다. 이러한 전통적인 데이터 기술들에 의존하는 기업들은 몇 가지 공통적인 어려움과 마주한다.

가장 먼저 언급되는 것은 다양한 데이터를 결합하고 통합하는 문제다. 대다수의 기업들은 수집한 데이터를 통합적으로 관리하지 못하고, 데이터를 종류별로 서로 다른 저장소(DB)에 분산해 저장·관리한다. 같은 조직 내에서도 마케팅 부서는 마케팅 부서의 DB를, 생산 부서에서는 생산 부서의 DB를 사용한다. 조직별로 DB가 산재돼 있다보니 데이터의 사일로(silo)화가 나타나고 이는 데이터 인프라의 운영에 대한 부담과 비용을 가중시킨다. 각각의 부서에서 서로 필요한 데이터를 주고받거나 통합하는 과정에서 불필요한 작업이 발생하기 때문이다. 또한 부서별로 데이터를 저장하는 형태도 모두 달라 결합에도 애로사항이 발생한다.

그나마 비용을 지불하고서라도 부서간의 데이터를 공유하고 통합할 수 있다면 상황이 나은 편이다. 부서간의 소통이 원활하지 못할 경우 이마저도 불가능하다. 서로 어떤 데이터를 보유하고 있는지조차 알지 못하기 때문이다. 기업이 100만큼의 데이터를 보유하고 있더라도, 타 부서의 데이터를 공유할 방법이나 시스템이 갖춰지지 않으면 우리 부서가 다루는 10만큼의 데이터만 활용할 수 있다.

전사적인 관점에서 보유하고 있는 데이터를 확인하고 서로 결합해 새로운 인사이트를 만들어내기 위해서는 사내의 모든 데이터에 대한 싱글뷰(single-view)가 필요하다. 최소한 우리 회사가 어떤 데이터를 가지고 있는지, 해당 데이터의 원 출처는 어디이며 어느 부서에서 관리하고 있는지, 이를 획득해 분석에 활용하기 위해서는 어떤 프로세스를 거쳐야 하는지 등은 데이터 활용도를 높이기 위한 가장 기본적인 정보다. 기업은 사내의 모든 데이터에 대한 정보를 담은 카탈로그 형태의 플랫폼을 구축해 이러한 문제를 해결할 수 있다.

카탈로그 형태의 데이터 플랫폼은 기존의 부서별 데이터 저장 방법을 유지하면서 데이터에 대한 접근성과 활용도를 향상시키는 관리 측면의 거버넌스(governance) 전략이다. 각 부서별 데이터 저장 프로세스는 그대로 유지하되, 전사적으로 데이터 보유 현황을 파악할 수 있는 플랫폼 레이어를 한 단계 추가한다. 각 부서의 데이터 저장 방식이 그대로 이어지므로 업무 프로세스에도 별다른 영향을 주지 않아, 큰 어려움 없이 비즈니스 연속성을 유지할 수 있다.

데이터 플랫폼이 효과적으로 운영되기 위해서는 높은 수준의 데이터 거버넌스가 필요하다. 단순히 전사 데이터를 확인할 수 있는 플랫폼이 완성됐다고 해서 이것이 전사적인 데이터 활용성을 높이지는 못한다. 사용자가 원하는 데이터를 찾을 수 있어도 이것을 사용하기 위해 복잡한 데이터 이관 및 변환 과정을 거쳐야 한다면 업무 효율이 크게 떨어지기 때문이다. 따라서 데이터 플랫폼으로 전사 데이터에 대한 접근성을 높이는 동시에, 거버넌스 차원에서 데이터의 요청·이관 절차를 시스템화하고 데이터의 결합·통합을 고려한 메타데이터 관리 등을 수행해야 한다.

데이터 레이크, 활용 어렵지만 쓰임새 높아

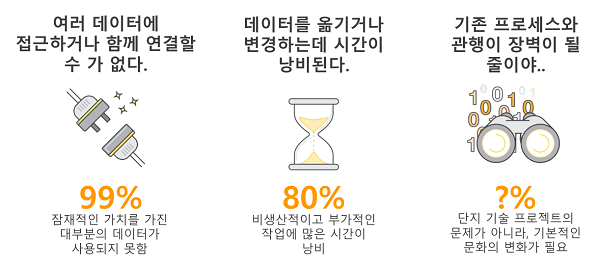

반면 산재돼 있는 데이터를 모두 하나의 저장소에 모아놓음으로써 데이터의 결합·통합 문제를 해결하는 것도 가능하다. 각 부서별로 독자적인 데이터 저장소를 운영하는 대신, 기업 내 모든 데이터를 담을 수 있는 거대한 데이터 레이크(Lake)를 구축하는 방식이다. 이는 데이터 플랫폼이 관리와 거버넌스 측면에서 접근하는 것과는 달리, 저장소 그 자체를 통합한다는 점에서 보다 근본적인 인프라 전략에 가깝다.

일반적인 DB나 DW는 수집된 데이터를 목적에 맞게 가공해서 정형화된 형태로 저장한다. 이때 데이터를 가공하는 기준을 스키마(schema)라고 하며, 각 DB와 DW의 구조와 성격을 정의하는 요소다. 데이터 레이크의 가장 큰 특징은 이러한 스키마 없이(schemaless) 모든 데이터를 원천 데이터(raw data) 그대로 저장한다는 점이다. 따라서 데이터를 저장할 때 고려해야 할 요소가 적어 어떠한 데이터도 담을 수 있다.

데이터 레이크에서 스키마는 데이터가 저장될 때가 아닌, 사용자가 데이터를 활용하고자 할 때 부여된다. 같은 데이터라고 하더라도 사용자가 어떤 스키마를 부여하느냐에 따라 완전히 다른 의미를 가지게 될 수 있다. 기존의 DB나 DW에 비하면 훨씬 높은 자유도를 가지고 있는 셈이다.

물론 스키마가 없다는 것이 장점만 가지고 있는 것은 아니다. 스키마가 없는 데이터 레이크는 사용자가 데이터를 보다 자유롭게 분석할 수 있게 되는 대신, 보다 높은 수준의 역량을 갖출 것을 요구한다. 올바른 스키마를 정의하는 것부터 모두 사용자의 역량에 달려있기 때문이다. 만약 사용자가 원천 데이터를 다룰 수 있을 정도의 역량을 보유하지 못했다면, 혹은 원천 데이터를 분석이 가능하도록 가공하는 데에 너무 많은 시간이 소요된다면 데이터 레이크는 잘못된 선택일 수 있다. 이럴 경우 데이터 레이크는 그저 까다로운 데이터들을 모아놓았을 뿐인 쓰레기장, 데이터 늪(swamp)으로 불리기도 한다.

기존의 DB와 DW는 사전에 정의된 스키마에 따라 가장 분석에 용이한 형태로 가공돼있는 상태다. 식품으로 치자면 이미 공장에서 한 번 가공을 거친 레토르트 식품에 가깝다. 포장지를 벗기고 정해진 조리법에 따라 굽거나 데우기만 하면 간편하게 요리를 완성할 수 있다. 대신 요리사의 의도가 개입될 여지가 적고, 가공 과정에서 필요없다고 생각된 부위가 잘려나갈(데이터가 삭제될) 수도 있다.

반면 데이터 레이크에 담긴 데이터들은 스키마가 없는 원천 데이터이며, 이는 밭에서 수확한 날것 그대로의 식자재라는 의미다. 당연히 훨씬 다양한 조리법을 적용할 수 있지만 그만큼 요리사의 수고가 많이 필요하다. 잘려나가는 것 없이 모든 부위를 온전히 활용할 수 있지만, 요리사의 역량이 부족하다면 실패한 요리, 다시 말해 전혀 쓸모없는 분석 결과가 만들어질 가능성도 있다.

최근 서비스되고 있는 데이터 레이크 제품들은 이러한 문제를 해결하기 위해 다양한 데이터 포맷과 타입을 사전에 정의해놓을 수 있도록 한다. 데이터를 저장할 때는 날것 그대로 하되, 데이터의 성격을 설명하는 태그를 붙이거나 향후 검색에 활용할 수 있는 패턴을 입력하는 등이다. 필요에 따라서는 다른 사용자들이 이용할 수 있도록 데이터 포맷이나 스키마를 미리 만들어놓는 경우도 있다. 즉 데이터 저장의 용이성과 원천 데이터 그 자체를 활용할 수 있다는 장점은 그대로 유지하되, 사용자가 필요로 할 요소들을 사전에 예측하고 가공하는 과정을 간소화·자동화함으로써 효율적으로 데이터 분석을 수행할 수 있도록 돕는다.

접근성 높이려면 거버넌스&보안 전략 갖춰야

거버넌스 측면에서 데이터 플랫폼 레이어를 추가하든, 모든 데이터 저장소를 통합한 데이터 레이크를 구축하든, 결과적으로 기업 내 모든 사용자가 모든 데이터에 접근할 수 있는 체계를 만드는 것이 중요하다. 이는 데이터를 다루는 주체가 극소수의 데이터 과학자(Data Scientist)에서 전사 직원으로 확장됨에 따라 중요성이 더욱 강화되고 있다.

과거에는 전문적인 역량을 갖춘 데이터 전담 조직만이 기업 내 데이터에 접근할 수 있었다. 생산, 마케팅, 영업 등 현업 비즈니스 조직들은 데이터가 필요할 경우 전담 조직에게 요청하고 답변을 기다려야 했다. 하지만 오늘날 데이터를 적극적으로 활용하는 기업들은 모든 비즈니스 영역을 데이터와 결합해 부가 가치를 창출하고 있으며, 데이터의 활용도가 높아진 만큼 데이터 전담 조직의 업무량이 크게 늘어났다. 이에 따라 간단한 데이터 검색이나 조회, 결합, 분석 등은 현업 비즈니스 조직이 직접 수행하도록 하는 셀프 서비스(Self-Service) 데이터 분석이 트렌드로 자리잡고 있다.

이를 위해 기업 내 데이터 관리 조직은 두 가지 문제를 해결해야 한다. 먼저 데이터에 대한 전문적인 지식이 없더라도 최소한의 데이터 조회·분석이 가능한 시스템을 구축하고 이를 전사 직원들에게 내재화시켜야 한다. 만약 현업 비즈니스 조직에서 간단한 수준의 데이터 조회나 분석을 수행할 수 있다면 데이터 과학자들의 업무를 크게 줄일 수 있으며, 데이터 과학자들은 AI나 머신러닝과 같은 기술들이 요구되는 보다 어렵고 복잡한 데이터 활용 사례에 집중할 수 있을 것이다. 현업 비즈니스 조직들의 데이터 접근성을 높이기 위해서는 손쉽게 사용할 수 있는 검색 기반의 데이터 포털을 구축하거나, 직관적이고 시각화된 데이터 분석 솔루션을 도입하는 것도 고려해야 한다.

다른 하나의 문제는 사용자들의 무분별한 데이터 접근을 제한해야 한다는 점이다. 일부 전담 조직만이 데이터에 접근할 때에 비해, 전사 직원들이 데이터에 접근할 수 있게 되면 관리가 어렵고 보안 사고가 발생할 위험이 높아진다. 기업은 데이터의 성격을 분석해 보안상 민감한 데이터가 있는지 여부를 확인하고, 사내에서 생성·저장·복사되고 있는 다양한 유형의 데이터들을 관리해야 한다. 특히 의료·금융 등 민감한 데이터나 특정 개인을 식별할 수 있는 개인정보 등은 비즈니스 지역 내에서 컴플라이언스 이슈를 발생시킬 수도 있기 때문에 각별한 관심이 요구된다.

또한 사전에 치밀한 업무 프로세스 분석을 통해 각 직원별로 접근 가능한 데이터를 제한할 필요가 있다. 이는 부서별/직급별/담당업무별로 세세하게 구분돼야 하며, 경우에 따라서는 각각의 직원 하나하나에 서로 다른 권한을 부여할 필요가 있다.

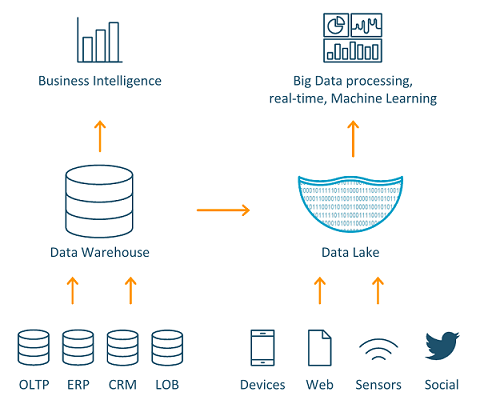

한편, 데이터에 대한 접근성을 높이기 위해 하이브리드 클라우드의 활용 또한 적극적으로 고려해야 한다. 최근 기업들은 데이터의 수집·저장·분석을 위한 단일한 플랫폼 전략을 마련하고 있으며, 가장 접근성이 높고 부서간의 장벽에 가로막히지 않을 수 있는 곳에 해당 플랫폼이 위치해야 한다고 요구한다. 실제 데이터는 온프레미스 서버에 구축되더라도 이에 대한 접근과 활용은 클라우드에서 이뤄질 수 있다.

또한 쿠버네티스(Kubernetes) 같은 컨테이너 기술이 보편화되고, 데이터 센터가 퍼블릭 클라우드 서비스처럼 작동함에 따라 하이브리드 클라우드 방식은 더 많은 유연성을 보장하면서도 관리가 용이하다는 장점을 갖추게 됐다. 따라서 하이브리드 클라우드는 데이터 활용도를 높이고자 하는 요구를 만족시키면서 효율적인 관리와 자원 활용이 가능해, 최선의 데이터 전략을 선택하고자 하는 기업들에게 뛰어난 선택지로 자리잡았다.

AWS는 기업들의 부서별로 산재된 DB들을 통합 관리하고 보안 및 거버넌스 관리를 개선하기 위해 ‘아마존 S3(Amazon Simple Storage Service, Amazon S3)’ 기반의 데이터 레이크 전략을 도입해야 한다고 설명했다.

‘아마존 S3’는 데이터의 종류나 형태에 제한 없이 안전하게 저장할 수 있는 오브젝트 스토리지다. 특히 스토리지에 대한 접근 권한을 상세히 설정할 수 있어, 기업 내 모든 데이터를 저장하고 모든 사원들이 접근하게 되더라도 안전하게 데이터를 저장 및 관리할 수 있다. 사용자뿐만 아니라 ‘아마존 S3’에 연결돼야 하는 애플리케이션에 대한 접근권한 설정이 가능해 유연한 서비스 운영이 가능하다. 이러한 접근권한 관리는 이미 별도의 서비스로 개발돼 있기 때문에, 도입 기업에서 생각하는 거버넌스 전략이 있다면 컨설팅을 통해 최적의 형태로 개발할 수 있다.

특히 ‘아마존 S3’ 기반의 데이터 레이크 구축을 고민하는 기업들을 위해, 페타바이트 단위의 데이터들을 손쉽게 ‘아마존 S3’로 옮길 수 있는 다양한 서비스들이 있다고 설명했다. ▲온프레미스 환경의 SW 어플라이언스를 클라우드 상의 ‘아마존 S3’로 손쉽게 이전할 수 있는 ‘AWS 스토리지 게이트웨이(AWS Storage Gateway)’ ▲전용 네트워크를 통해 보다 보안성이 높고 개인화된 연결을 지원하는 ‘AWS 다이렉트 커넥트(Direct Connect)’ ▲페타바이트 단위의 대용량 데이터 이동을 지원하는 데이터 전송 서비스 ‘AWS 스노우볼(AWS Snowball)’·‘AWS 스노우볼 엣지(AWS Snowball Edge)’ 등이다.

“데이터레이크 on AWS”로 최적의 데이터 전략 수립

한 걸음 더 나아가, AWS는 기업들을 위한 최적의 데이터 전략을 ‘데이터레이크 on AWS’를 제안한다. 이미 AWS의 클라우드 서비스 상에는 데이터 레이크를 구성하기 위한 모든 서비스들이 마련돼 있다. 데이터의 저장·관리·보안 등을 위한 개별 서비스들은 물론, 온프레미스 인프라에 축적된 데이터를 AWS 클라우드로 이전하기 위한 다양한 방법들을 제공한다. Q. 데이터 레이크 도입을 고려하는 기업들에게 조언한다면? 또한 데이터 전략 전환을 준비하기 위해서는 C레벨의 강한 리더십이 필요하다. 작은 DB 하나를 교체하는 것이 아니라 기업 전체의 전략을 바꾸는 것이기 때문이다. 고객사의 강한 의지와 노력만 뒷받침된다면, AWS와 함께 데이터 레이크를 기반으로 한 최적의 데이터 전략을 수립할 수 있을 것이다. |

한편 AWS는 자사의 클라우드 서비스 상에서 특정 상용DB에 종속되지 않고 다양한 오픈소스 기반 DB를 선택해 사용할 수 있는 DB 프리덤(Database Freedom) 전략에 대해 소개했다. 일반적으로 상용DB 제품은 도입 및 유지·관리에 많은 비용이 소요될뿐더러 특정 벤더의 제품에 종속될 위험도 있다. 반면 AWS는 클라우드 서비스 상에서 ‘마이SQL(MySQL)’이나 ‘마리아DB(MariaDB)’와 같은 오픈소스DB는 물론, ‘아마존 오로라(Amazon Aurora)’와 같이 상용DB의 성능과 가용성을 보유한 핵심적인 DB 제품도 지원하고 있다. 이외에도 ‘다이나모DB(Amazon DynamoDB)’나 ‘도큐먼트DB(Amazon DocumentDB)’ 등 NoSQL DB들도 사용 가능하다. 따라서 고객은 보다 낮은 비용으로 다양한 DB들을 선택해 최적의 데이터 전략을 수립할 수 있다.

다양한 데이터 저장소에 위치한 데이터를 효과적으로 파악하고, 어떤 데이터가 어디에서 어떻게 관리되고 있으며 유사한 데이터는 무엇인지를 인식하기 위해서는 데이터 거버넌스 전략이 매우 중요하다. 또한 데이터 거버넌스를 통해 데이터를 효과적으로 파악할 수 있다 하더라도 사용자가 필요한 데이터를 요청하고 활용하는 과정이 복잡하다면 업무 효율성이 크게 떨어진다. 오라클은 이러한 문제를 해결하기 위해 데이터 가상화(Data Virtualization)가 필요하다고 강조한다.

데이터 가상화는 사용자가 데이터의 실제 위치를 파악할 필요없이 하나의 인터페이스로 모든 데이터를 접근하고 처리하는 체계를 의미한다. 이를 위해 오라클은 ‘클라우드 SQL(Cloud SQL)’ 서비스를 제공하고 있다. ‘클라우드 SQL’ 서비스는 다양한 오브젝트 스토리지, 오라클 DB, 하둡(Hadoop), 카프카(Kafka) 등을 오라클 SQL로 손쉽게 조회하고 접근할 수 있다. 사용자는 데이터가 어디에 위치하고 있는지 고민하지 않고, ‘클라우드 SQL’이라는 단일 접점에서 범용적인 SQL을 통해 사내의 모든 데이터에 접근할 수 있다.

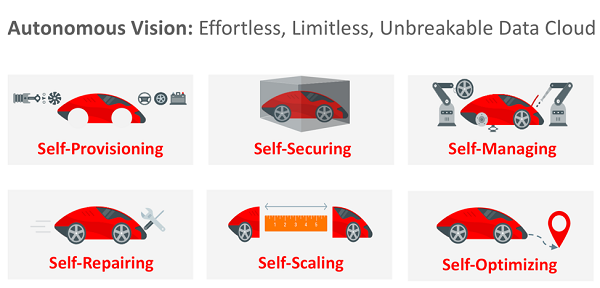

오라클은 그동안 온프레미스 환경에서 축적한 엔터프라이즈 DBMS 역량을 바탕으로 IaaS, PaaS, SaaS를 아우르는 통합 클라우드 플랫폼을 구축하고 있다. 자율 관리(self-driving), 자율 보안(self-securing), 자율 복구(self-securing) 기능을 탑재한 ‘자율운영(Autonomous)’ 기술을 핵심 서비스로 제공하고 있으며, 이를 기반으로 보다 확장된 개념의 ‘자율운영 클라우드(Autonomous Cloud)’를 지원한다. 특히 지난해에는 국내에 ‘자율운영 클라우드’ 기술을 기반으로 한 2세대 데이터센터를 오픈, 클라우드 엔터프라이즈 서비스를 강화하고 있다.

특히 자율운영 기술을 가장 효과적으로 활용할 수 있도록 ‘융합형 DB(Converged Database)’를 제공한다. ‘융합형 DB’는 데이터의 종류나 특징을 가리지 않고 단일한 아키텍처에서 관리·운영할 수 있는 DB다. 이는 기존의 단일 목적형(Single-purpose) DB들이 데이터 종류와 업무 형태에 따라 별개의 DB를 구축해야 했던 것과 달리, 하나의 데이터 플랫폼 상에서 다양한 데이터들을 효율적으로 관리할 수 있도록 돕는다.

단일한 접점에서 모든 데이터를 통합 관리할 수 있게 되면서 데이터 분석 속도 역시 향상된다. 데이터에 대한 접근성이 높아질 뿐만 아니라, 복수의 처리·분석 워크로드를 수행할 수 있도록 최적화된 분석 도구와 애플리케이션을 제공해 시스템 부하를 최소화했기 때문이다.

|

HMM, 오라클 클라우드로 효율적인 서비스 제공·운항 안정성 향상  HMM은 오라클과 함께 클라우드 기반 차세대 IT시스템 구축, HMM의 컨테이너 및 벌크사업을 지원하기 위한 클라우드 환경을 마련하고, 향후 전사자원관리(ERP), 인사시스템 등 모든 애플리케이션과 데이터를 오라클 클라우드로 단계적 이전한다고 발표했다. 이를 통해 전 세계 화주 및 내부 시스템 사용자들에게 보다 빠르고 안정적인 IT서비스를 제공할 수 있게 됐다. HMM은 클라우드 기반의 차세대 IT시스템 전환에 발맞춰 블록체인, 사물인터넷(IoT), 빅데이터, AI 등 4차 산업혁명 관련 주요 신기술을 해운산업에 적용할 계획이다. 이번 오라클 클라우드로의 단계적 이전을 통해 고객들에게 효율적인 서비스를 제공하고 운항 안정성을 더욱 향상시킬 수 있을 것으로 전망했다. |

클라우데라는 지난해 ‘CDP(Cloudera Data Platform)’ 출시와 함께 통합 데이터 플랫폼 기업으로의 변화를 선언했다. 대표적인 ‘하둡(Hadoop)’ 배포판 벤더이자 빅데이터 전문기업에서 벗어나, 고객의 전사적인 데이터 전략을 모두 지원할 수 있는 ‘CDP’를 중심으로 새롭게 출발하겠다는 것이다.

‘하둡’은 오픈소스 기반 대규모 데이터 분석 처리 서비스다. 클라우데라는 ‘하둡’의 아버지인 더그 커팅(Doug Cutting)이 수석 아키텍트를 맡고 있으며, 그동안 ‘하둡’ 배포판인 ‘클라우데라 엔터프라이즈(Cloudera Enterprise)’ 시리즈를 통해 고객들이 대량의 데이터를 분석하고 새로운 가치와 인사이트를 창출할 수 있도록 지원해왔다. 특히 지난해에는 ‘하둡’ 기반의 빅데이터 전문기업인 호튼웍스를 합병하면서 보다 고도화된 기술력을 보유하게 됐다.

‘CDP’는 클라우데라와 호튼웍스의 역량을 결합해 완성됐다. 고객이 보유한 모든 데이터의 수명주기(data lifecycle)를 관리할 수 있는 클라우드 네이티브 서비스를 제공하며, 사용자가 복잡한 데이터를 명확하고 실행 가능한 통찰력으로 전환할 수 있도록 지원한다. SDX(Shared Data Experience) 기술을 통해 수 시간 이내에 자동으로 데이터 레이크가 생성되며, 개별 사용자들은 동일한 데이터 레이크를 공유하면서도 개별화된 포인트 솔루션을 사용하는 것 같은 환경을 제공한다. 이를 통해 직원들의 업무 역량과 효율성을 유지하면서도 전체 데이터 플랫폼을 일관되게 통제할 수 있다.

특히 ‘CDP’에는 클라우데라와 호튼웍스가 제공하던 다양한 서비스들이 결합돼 있다. 예를 들어 머신러닝 라이프사이클 전체를 통합 관리하는 ‘CDSW(Cloudera Data Science Workbench)’는 본래 별개의 서비스로 제공되던 기능이다. ‘CDSW’는 ‘도커(Docker)’를 활용해 사용자들이 격리된 공간에서 ‘스파크(Spark)’·‘임팔라(Impala)’와 같은 ‘하둡’ 컴포넌트로 머신러닝 프로젝트를 수행할 수 있도록 돕는다. 관리자는 머신러닝을 활용하는 전체 사용자 수와 프로젝트 운영 현황을 실시간으로 모니터링하고, 머신러닝 엔진 프로필 생성이나 인증 설정 등을 수행할 수 있다.

또한 ‘클라우데라 매니저(Cloudera Manager)’ 기능을 활용하면 테이블 메타데이터나 세분화된 접근 권한 관리, 계보관리(Lineage), 인증(SSO) 등 다양한 보안, 개인 정보보호와 규정 준수 기능을 손쉽게 이용할 수 있다. 특히 데이터에 대한 접근성을 향상시키면서도 보안성을 함께 갖추기 위해 보안 프로세스의 대부분을 자동화했다. 이는 보안 체계가 복잡하고 준수하기 어렵다면 사용자들이 이를 우회하는 방법을 찾으리라는 판단에서다. 클라우데라는 ‘CDP’ 상에서 대부분의 보안 기능을 자동화함으로써 사용자가 데이터에 접근할 때 귀찮은 보안 절차를 경험하지 않도록 하고, 관리자에게는 치밀하고 세밀한 보안 기능들을 제공함으로써 데이터를 안전하게 관리할 수 있도록 돕는다.

티맥스는 국내외 데이터 분석 트렌드가 OLAP/리포팅 중심에서 현업 비즈니스 조직이 스스로 데이터를 분석해 인사이트를 발굴하는 셀프 서비스 BI로 발전해왔다고 설명했다. 특히 최근에는 머신러닝 및 AI 분석을 활용한 데이터 사이언스 BI로 발전하고 있다. 이에 따라 글로벌 벤더들은 인수합병을 통해 데이터 수집·저장·분석·예측·시각화까지 다양한 영역을 아우르는 특화된 개별 솔루션들을 제공한다. 하지만 고객은 실질적인 데이터의 분석 및 활용보다 다양한 솔루션을 동시 활용함으로써 생기는 인터페이스 이슈와 높은 도입 비용에 따른 부담을 느끼고 있다.

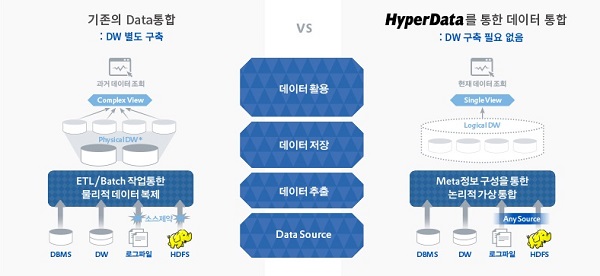

티맥스는 이러한 데이터 활용의 기본적인 특성을 이해하고, 고객이 가진 데이터에 대한 부담을 해결하기 위해 데이터 수집·저장·예측·분석 등 모든 과정을 하나의 플랫폼 환경에서 통합적 수행할 수 있는 AI 기반 통합 데이터 플랫폼 ‘하이퍼데이터(HyperData)’를 제공한다. ‘하이퍼데이터’는 단일 플랫폼 상에서 다양한 유형의 데이터를 수집 및 저장할 수 있는 데이터 가상화 플랫폼이다. 이기종 시스템 간의 데이터 인터페이스 및 연동을 지원하며, 대용량 데이터 분석 시에도 정합성 유지가 가능해 높은 수준의 데이터 품질 관리를 보장한다.

또한 가상화된 데이터에 대해 카탈로그 기반의 데이터 표준화를 수행한다. 이를 통해 메타데이터를 구성 및 관리함으로써 사용자가 활용할 수 있는 논리적 DW(Logical DW)를 구성할 수 있다. 이외에도 클라우드 상에서 데이터 분석을 위한 개발 환경을 지원하며, 사용자가 플로우(Flow) 기반의 데이터 처리와 다양한 시각화 및 탐색 기능을 통해 손쉽게 데이터를 활용할 수 있도록 돕는다.

아울러 탐색적 데이터 분석(Exploratory Data Analysis, EDA)을 지원해 데이터의 구조와 변수 등을 확인할 수 있다. EDA는 데이터의 크기나 변수, 타입 등을 분석하고 통계와 시각화를 활용해 데이터 그 자체를 직관적으로 파악할 수 있도록 돕는 과정이다. 원천 데이터에 포함돼 있는 결측값, 이상치(Outlier), 익명화된 변수 등 다양한 노이즈를 제거 혹은 변환함으로써 보다 좋은 데이터를 생성한다. 이렇게 만들어진 데이터는 다양한 AI나 머신러닝 모델에 효과적으로 활용될 수 있다.

한편 티맥스는 규모가 작은 스타트업이나 중소기업들이 비즈니스 규모 변화에 민첩하게 대응하기 위해 유동적인 인프라를 갖춰야 한다고 조언했다. 이를 위해서는 인프라 규모를 가변적으로 운영할 수 있도록 클라우드 상에 데이터 저장소를 구축해야 한다. 클라우드의 유동적인 인프라는 스타트업의 가파른 성장에도 대응하면서 보다 비용 효율적으로 운영할 수 있다.

이러한 클라우드 데이터 저장 수요에 대응하기 위해, 티맥스는 올해 한에 클라우드 기반 DBMS ‘티베로8(Tibero8)’을 출시할 계획이다. ‘티베로’는 티맥스데이터의 대표 DBMS 제품으로, 독자 기술로 개발한 액티브 클러스터링 기술인 TAC(Tibero Active Cluster)를 탑재하고 있다. 올해 출시하는 ‘티베로8’에는 TAC 기술을 보다 발전시켜 클라우드 상에서의 무한대 확장을 지원한다는 계획이다.